這次的TensorFlow的2020年研討會還有正式公開的工具叫做公平性衡量指標(Fairness Indicators),這個是非常進階的機器學習工具。而公平性衡量指標(Fairness Indicators)是近年機器學習有關公平性研究熱門的研究領域,主要用於二元、多分類的機器學習題目。

過去的評估工具在大量數據集、大量的模型的情境下處理都不太好,Google需要十億個客戶系統上運作一個穩定的機器學習模型評估工具就變得非常重要。該工具評估的項目會包含:數據的分佈、模型的性能、多個不同參數下的表現。

上述的影片就是Google介紹如何透過公平性衡量指標(Fairness Indicators)概念實現公平的機器學習。

ML Practicum: Fairness in Perspective API相關的課程

https://developers.google.com/machine-learning/practica/fairness-indicators

在也指出幾個很重要的機器學習問題

從上圖上來觀察可以看到機器學習在各個流程上

包含從定義問題、準備資料、建立模型、部署、迭代的過程

都會出現人的主觀行為,進而影響到學習的偏差。

因此Google提出了一個機器學習公平性研究的工作流程

包含透過Tensorflow的資料驗證工具、模型分析工具、互動式視覺化工具來達到

改善機器學習有人類偏差的問題。

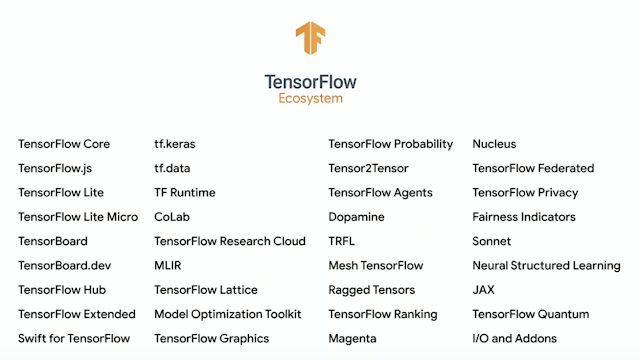

在這些介紹後,大家一定很好奇工具會有哪些。

首先這個必須學會TensorBoard,這個工具以前主要是用來視覺化模型的表現,在2.0之後功能就變得非常的多元。理解了TensorBoard(TensorFlow視覺化)之後,就可以理解以下的工具:

Tensorflow Data Analysis (TFDV):主要用於分析數據集的分佈。

Tensorflow Model Analysis (TFMA):主要用於分析模型的效能、也包含公平性指標可以分析不同模型表現。

The What-If Tool (WIT):主要透過互動的方式分析模型。

光說明沒有範例不夠看,所以請透過下面連結,可以直接到工具的範例中去深讀內容。

Tensorflow Data Analysis (TFDV)

Tensorflow Model Analysis (TFMA)

What-If Tool Dashboard